最終更新:

haruyama_seigo 2011年05月17日(火) 12:46:16履歴

haruyama_seigo 2011年05月17日(火) 12:46:16履歴

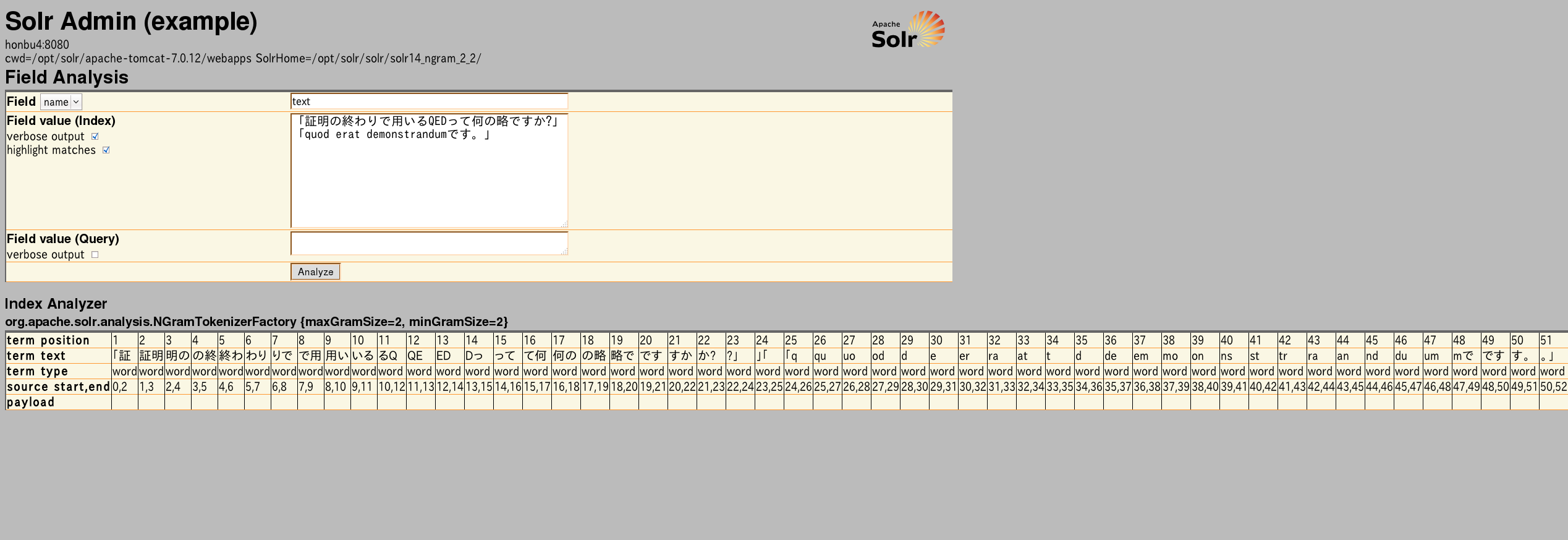

Lucene/Solr のNGramTokenizer (minGramSize="2" maxGramSize="2")

- いわゆるbi-gram

- SolrのWikiには記述がない

- NGramTokenizerは1024文字までしか処理しない. 利用したデータには1024文字以上の項目が多数あるのですべてがインデックスされていない.

schema.xml

<fieldType name="text_ja" class="solr.TextField" positionIncrementGap="100">

<analyzer>

<tokenizer class="solr.NGramTokenizerFactory" minGramSize="2" maxGramSize="2"/>

</analyzer>

</fieldType>

- カテゴリ:

- インターネット

- インターネットセキュリティ

最新コメント